近日,我院信息科学与技术学部计算机科学与技术研究所博士后姜婧妍的学术论文《多版本模型与多数据模型自适应推理服务》(Joint Model and Data Adaptation for Cloud Inference Serving)入选第42届The IEEE Real-Time Systems Symposium (IEEE实时系统研讨会,以下简称RTSS),该论文指导老师为王智副教授和夏树涛教授。

图1:姜婧妍

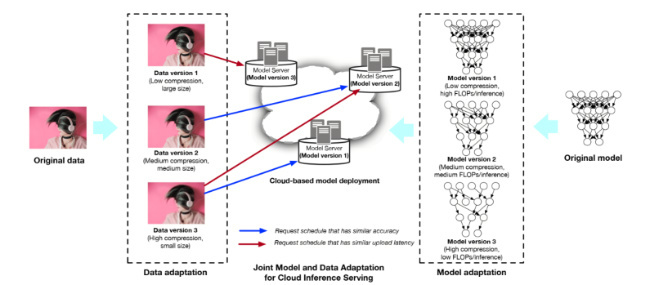

深度学习推理服务面临一大技术难题——如何有效地进行深度模型的大规模部署和请求调度,从而满足海量用户的推理需求,并获得延迟和准确率保障。该论文解决了传统推理系统局限于降低计算资源,而忽略准确率、延迟之间的关联关系的难题,提出了一种联合模型-数据的深度模型推理服务解决方案A2。该方法在满足用户对推理服务响应时间和准确性的基础上,利用计算资源和带宽资源之间的关联规律,进行模型版本和数据版本的联合规划,实现推理请求服务吞吐最大化。

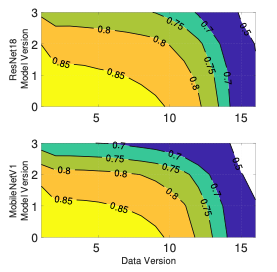

该论文具有以下主要创新点:首先,论文中提出的模型揭示了影响深度学习推理服务的准确性和延迟的重要因素是不同大小输入数据和多版本模型可以实现相似的延迟和准确率,如图2所示。其次,模型部署和推理请求调度的联合多目标优化建模,并实现其近似算法,满足请求延迟和准确性约束的吞吐最大化:将不同数量的不同模型版本部署到不同地理位置的服务器,将用户上传数据压缩成相应版本并调度到满足精度和延迟的服务器进行推理。在亚马逊云AWS弹性计算云资源部署和评估中,A2可以将系统运行成本降低50%,同时满足精度和延迟时间约束。该研究受科技部重点研发(2018YFB1800204)、基金委面上(61872215)等项目资助。

RTSS是由IEEE主办的实时系统及嵌入式系统领域的顶级国际会议,自1979年首次召开以来,每年举办一次,每年接受大约30篇论文,汇聚和发布该领域国际上最新的研究成果。该会议是计算机学会推荐A类会议,是实时系统领域公认度最高的会议之一。

图2:实现多版本深度模型云和边缘部署,以及精度和延迟联合感知的请求调度

图3 :不同输入数据和多版本模型可以实现相似的延迟和准确率

文、图:姜婧妍

编辑:黄萧嘉